Después de que hace unas horas se decretase la pandemia global por corona virus, quería mostraros los resultados de dos matemáticas en relación con el tema, por que sí, las matemáticas también sirven para prevenir mayor número de contagios de una enfermedad (como vimos en entradas anteriores) o para predecir cómo va a evolucionar. Aunque en estos momentos lo que recomienden las autoridades sanitarias es lo que hay que hacer y lo más recomendable es evitar el contacto social.

Introducimos el Dilema del prisionero. La conclusión básica de este planteamiento, muy conocido en Teoría de Juegos es que, en la mayoría de situaciones, la cooperación conduce al bien común (a cambio de pequeños sacrificios individuales). La situación es la siguiente: pensemos en dos personas A y B que están contagiados pero no presentan síntomas. En la siguiente tabla se muestran los posibles escenarios y consecuencias esperadas de cada caso.

(Este argumento es el que plantea Clara Grima y otros autores en el libro Las matemáticas vigilan tu salud)

Por tanto, no se trata de que tú no te contagies, sino de que no nos contagiemos ninguno.

Aislarse, en la medida de nuestras posibilidades, en estas circunstancias, como vacunarse, es un acto de altruismo que todos deberíamos hacer.

@AnaBayes controla de modelos matemáticos y nos cuenta esto:

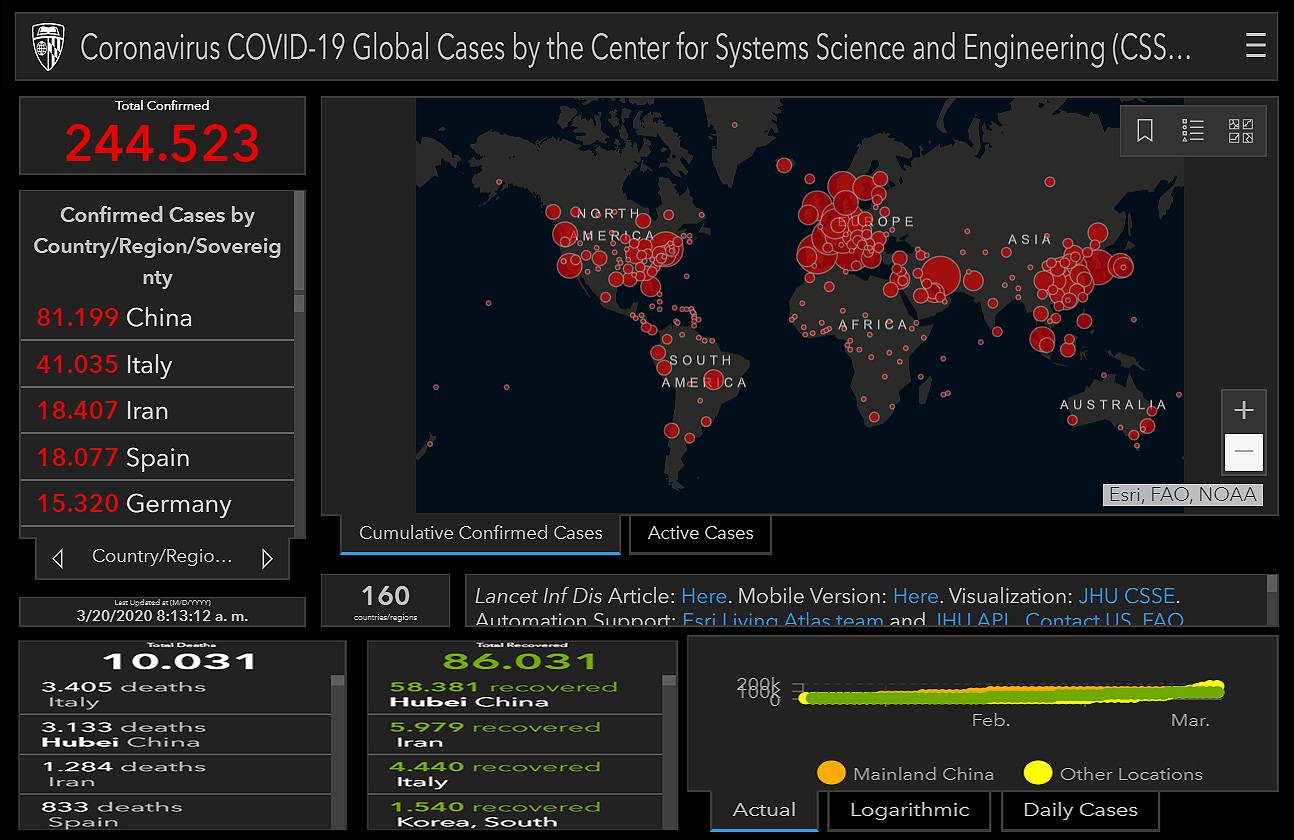

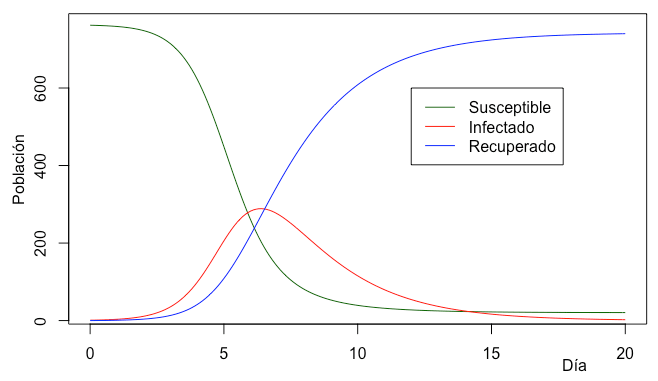

Imaginad un aula llena de personas donde 2 o 3 tienen la infección. Esas personas pueden contagiar a otras 2 personas cada una (en entradas anteriores ya vimos qué era R0). Si dejamos que el sistema se mueva sin hacer nada, efectivamente, los contagios crecerán de forma exponencial y, al final, todo el mundo estará contagiado. Sin embargo, solo hace falta un poco de control, aislar algunas zonas, para ver cómo el crecimiento se ralentiza muchísimo y dejamos de tener el famoso modelo exponencial. Si, además, metemos en la ecuación que a lxs enfermxs se les trata y se curan (en la mayor parte de los casos) eso genera otro cambio en el modelo que pasa a tener 3 tipos de personas, el modelo SIR (Susceptibles, Infectadas y Recuperados). Depende de cómo sea la enfermedad (y ahí es donde no tenemos datos) puede que las recuperadas vuelvan a ser susceptibles o no y eso también cambia el aspecto del sistema. En cualquier caso, lo importante es mantener la curva de infectados lo más plana posible para evitar el colapso del sistema

La prevalencia de una enfermedad (E) es de 10 por cada 100.000 habitantes (0.01%). Aplicamos a una persona al azar un test que tiene una probabilidad del 99.9% de acertar. El test dice que la persona está enferma (A). ¿Cuál es la probabilidad de que la persona tenga realmente la enfermedad?

Recapitulemos: tanto la sensibilidad como la especificidad del test son del 99.9%, así que

- la probabilidad de que dé positivo si está enferma es del 0.999, P(A|E) = 0.999.

- igual que la probabilidad de que dé negativo si no está enferma, P(A'|E')=0.999. (E' es el complementario de E, i.e., el suceso la persona No esté enferma y A' es el suceso el test dice que la persona no está enferma, el complementario del suceso A).

Si ya ha ocurrido A, buscamos entonces P(E|A). Aplicamos el Teorema de Bayes:

P(E|A) = P(A|E)*P(E) / [P(A|E)*P(E) + P(A|E')*P(E)]

Dado que P(A|E') = 1- P(A'|E') y P(E') = 1 - P(E),

P(E|A) = 0.999*0.0001 + 0.001-0.9999 = 0.0908.

La probabilidad de que la persona realmente tenga la enfermedad es de 0.0908 (9.08%), luego es mucho más probable que no la tenga.

¿Cuál es el motivo de que sea tan baja? La prevalencia inicial.

Si aumentamos la prevalencia a 100 casos por cada 100.000 habitantes (0.1%), la probabilidad anterior aumentaría a 0.5 y, si lo hiciéramos a 1000 casos por cada 100.000 (1%), y sería de 0.91. ¿Verdad que te fiarías más de este test?

Si queremos elevar la probabilidad de que los positivos sean verdaderos hace falta elevar el valor predictivo del test, lo cual es más una cuestión técnica, pero también se puede elevar la probabilidad de estar enfermo a priori (seleccionando bien a quién se hace la prueba!!).

Esta selección a veces es complicada, por lo que hay estrategias para conseguir maximizar el éxito.

También, de mano de @AnaBayes, otro aspecto sería seguir la estrategia de repetir la prueba varias veces, incluso jugando con la sensibilidad y especifidad (siempre dentro de unos límites coherentes), para aumentar las posibilidades.